Edge AI Foundation’s Austin 2025 便り

The following blog post is from Jack Ferrari, Edge AI Product Manager, Joe Sanford, Senior Application Engineer, and Reed Axman, Strategic Partner Manager.

テキサス州オースティンで開催された Edge AI Foundation のカンファレンスに参加しました。このイベントは、学者、研究者、ビジネスリーダー、エンジニアを集め、AI モデルを実験室から実際のエッジデバイスへと展開することに焦点を当てています。3 日間にわたる魅力的なイベントで、MathWorks のチームは多くの参加者・講演者と交流しました。

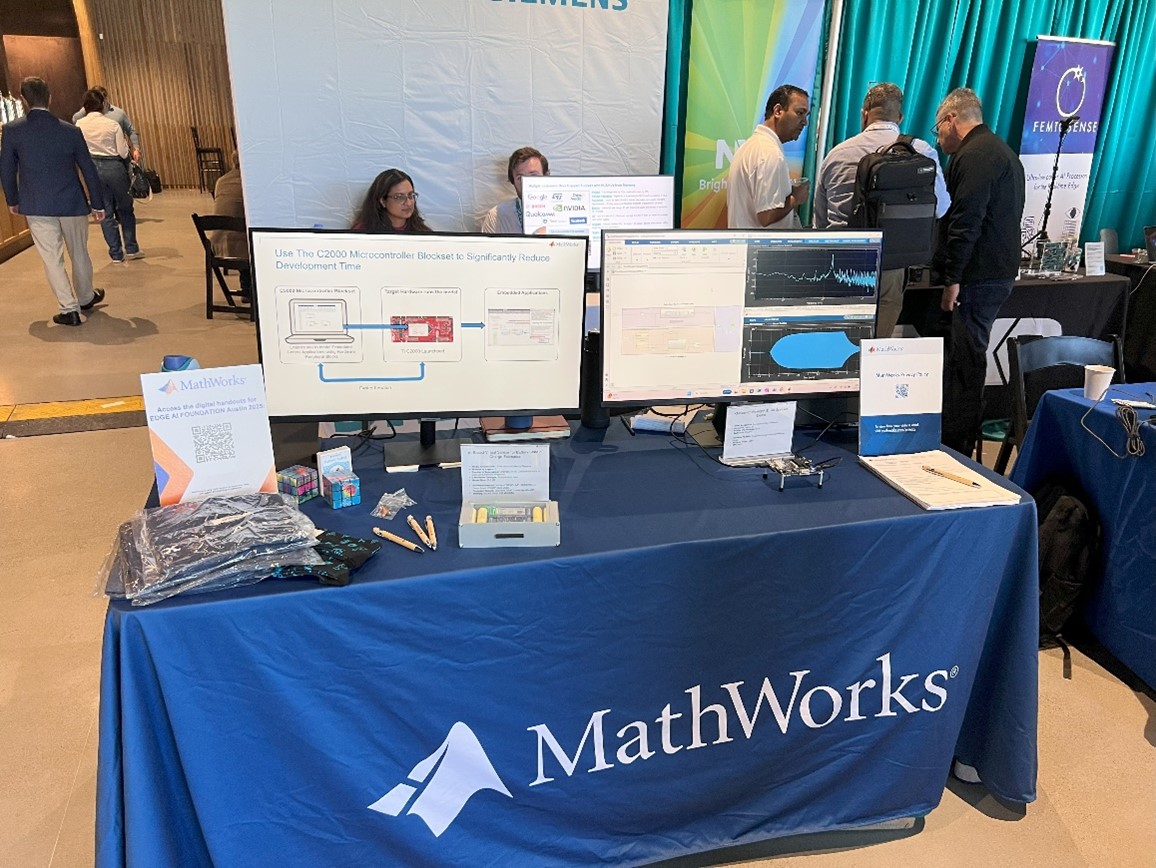

Edge AI のスポンサーとして MathWorks はデモブースを設け、2 つのライブデモを行い、さらに MATLAB と Simulink を使用してモーター制御のための AI モデルを開発する方法を紹介するハンズオンワークショップを実施しました。大きく成長している Edge AI コミュニティから学び、情報を共有し、貢献もさせてもらう素晴らしい機会でした。

Figure 1: Edge AI Foundation 2025 での MathWorks ブース

MathWorks ブースでのデモ展示

AI モデルの開発やエッジデバイスへの展開のプロセスを 、MATLAB と Simulink を使って加速する方法を紹介するデモを 2 つ発表しました。

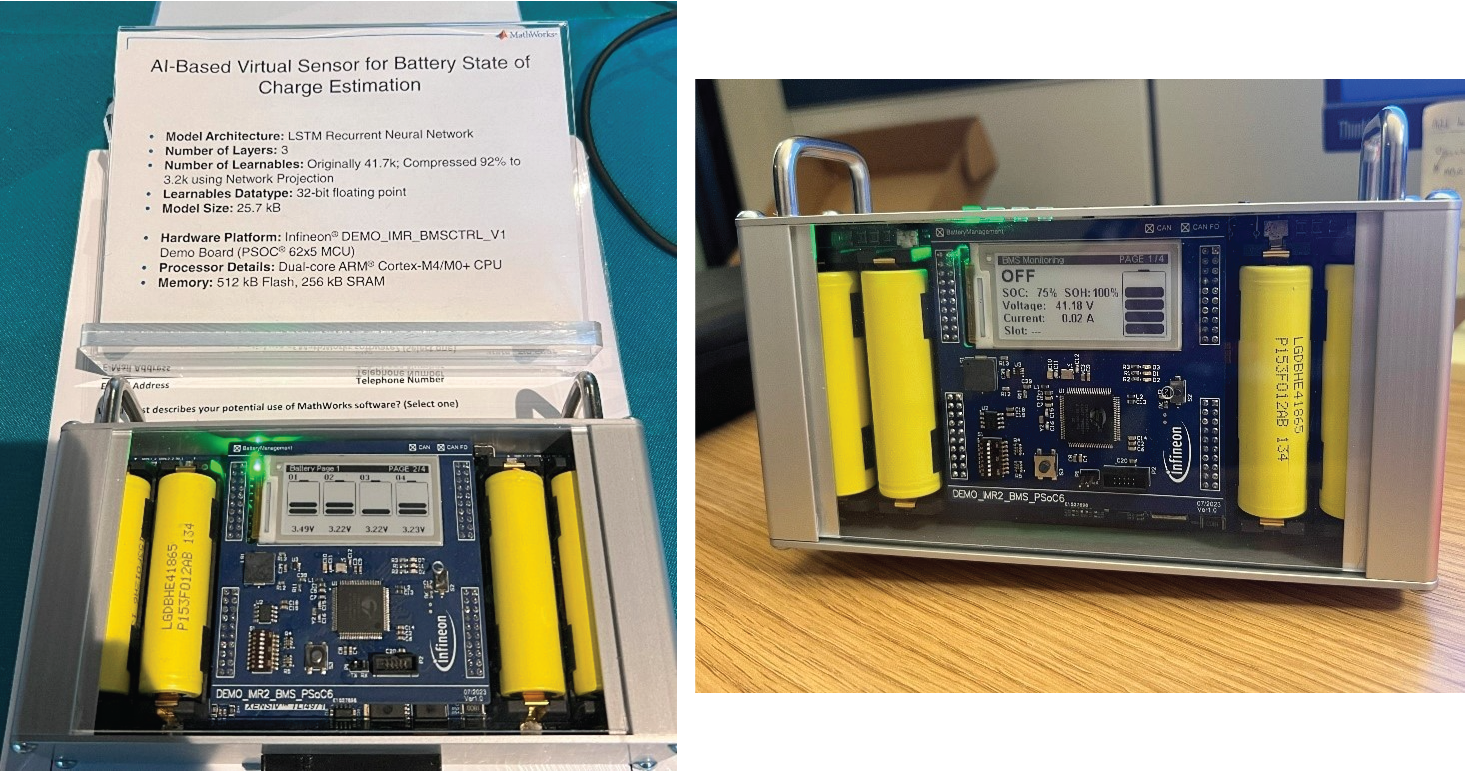

バッテリー充電状態の仮想センサー

このデモでは、AI ベースの仮想センサーが、電圧、電流、温度の測定値からリチウムイオンバッテリーの充電状態(SoC)をリアルタイム予測する様子を示しました。バッテリーの SoC 推定は、多くのバッテリー駆動システムにとって非常に重要であり、直接測定することが難しい場合や不可能な場合があります。ニューラルネットワークのようなデータ駆動型モデルを使用することで、関連する測定値に基づいて正確な予測が可能になります。

このデモでは、Deep Learning Toolbox を使用して、実際のデータセットで簡単な LSTM モデルを学習し、リソース制約のある組み込みデバイスへの実装するために neural network projection (ネットワーク投影)を用いました。ネットワーク投影により LSTM モデルの学習可能なパラメータ数は約 4 万から3千 へと 92% 削減され、テストデータセットでの精度低下はありませんでした。圧縮後のモデルパラメータのサイズは 25.7 kB でした。

MATLAB Coder を使用して LSTM モデルからスタンドアロンの C コードを生成し、デモキットの既存の BMS ファームウェアに統合しました。このデモで使用されたハードウェアは、Infineon Mobile Robot で使用されている BMS コントローラーに基づいています。

Figure 2: バッテリーの SoC 推定仮想センサーデモ

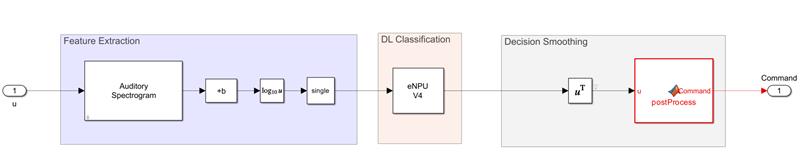

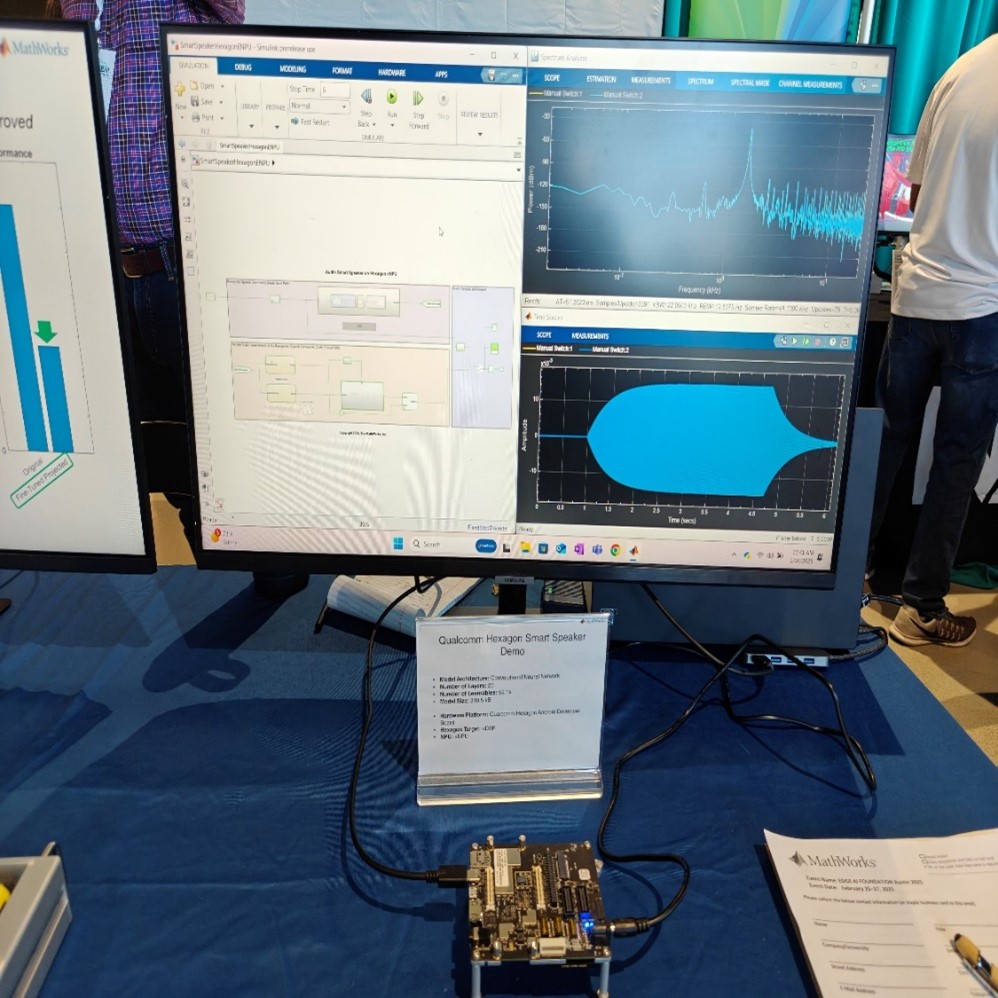

スマートスピーカーのウェイクワード(wake word)検出

このデモでは、Simulink と Embedded Coder Support Package for Qualcomm Hexagon Processors を使用して、Qualcomm の Hexagon 上で音声コマンド認識のための畳み込みニューラルネットワーク(CNN)の実装を行いました。デモはスマートスピーカーのウェイクワード検出を対象としています。Hexagon 向けの最適化されたコード生成の利点を強調し、このハードウェアサポートパッケージがQualcomm ハードウェアの使用をどれだけ簡素化するかを紹介しました。Qualcomm のソフトウェアツールに関する専門知識を持たずにハードウェアを活用でき、AI モデルのeNPU への展開を 5 分以内で取りかかることが可能になります。

Figure 3: スマートスピーカーデモで使用した Simulink モデル

Figure 4: Qualcomm Hexagon eNPU に実装したウェイクワード検出デモ

これらのハンズオンデモに加えて、Deep Network Designer 、Analyze for Compression、Diagnostic Feature Designer、Classification Learner、Experiment Manager、およびSignal Labeler や Image Labeler などのアプリの即興デモも行いました。

Figure 5: MathWorks ブースでの一幕

STMicroelectronics と共同で行ったワークショップ

“Rev it up: Deploy Tiny Neural Network to Boost Embedded Field-Oriented Controls of Electrical Drives”と題したワークショップでは、参加者にモーター制御アプリケーションで使用される古典的な比例積分(PI)コントローラーを改善するために、小型のニューラルネットワークを設計、最適化、およびベンチマークする課題を実施しました。参加者は、Simulink シミュレーションから合成トレーニングデータを生成し、Deep Learning Toolbox でさまざまな深層学習モデルをトレーニングおよび圧縮し、ST Edge AI Developer Cloud からアクセス可能なリモートボードファーム上でモデルの実行時性能を評価しました。

このワークショップを開催する機会を与えてくれた Edge AI Foundation と、共に発表してくれた STMicroelectronics の Dr. Danilo Pau に心から感謝しています。参加者からの称賛と改善提案を聞くことができて嬉しかったです。多くの参加者は、90 分のイベントの中でトレーニングデータの生成から STM32 ハードウェアへの展開とベンチマークまで、エンドツーエンドのワークフローを完了させていました。このワークショップについて詳しくは、ワークショップの概要とリポジトリをご覧ください。

Figure 6: Rev it up: Deploy Tiny Neural Network to Boost Embedded Field-Oriented Controls of Electrical Drives ワークショップの様子

まとめと業界トレンド

このカンファレンスでは、急速に進化するエッジ AI の世界に関する洞察にあふれていました。オースティンでの 3 日間で特に注目を集めたのは次のトレンドです。

- 物理 AI とロボティクスへの関心の高まり:ロボットや物理環境と相互作用する他の自律的なシステムにAIを統合することへの関心が顕著に高まっています。システムがより複雑になるにつれて、包括的な設計とテストプロセスを通じてその信頼性と効果を確保することが重要になります。これらのシステムを迅速にプロトタイプ化し、厳密にテストする能力が、成功した展開と安全な運用の鍵となるでしょう。

- 専用ニューラルプロセッシングユニット(NPU)の拡大:かつては PC やスマートフォンに限られていた NPU が、より多くのマイクロコントローラーや IoT デバイスに進出し続けています。この変化は、従来の CPU と比較して、電力効率と性能の向上の可能性を示しており、エッジでのデータ処理における重要な進化を示しています。MATLAB ユーザーで NPU に AI モデルを展開することに興味がある方は、ぜひお知らせください!皆さんの洞察と経験が、追加の NPU ターゲットへのサポートを検討する中で貴重な情報になります。

- ニューラルネットワーク圧縮アルゴリズムの進展:新しい圧縮技術は AI モデルのサイズと計算要求を大幅に削減し、ますます複雑なモデルをエッジデバイスに展開することを可能にしています。カンファレンスでは、Nota AI が発表した SplitQuant に特に感銘を受けました。私たちとしてはもちろん MATLAB の neural network projection も推しています。

エッジ AI コミュニティの継続的な進歩に心から感動しています。Edge AI カンファレンスのようなイベントは、刺激的でお互いの協力の精神を育んでいます。この分野の進展には期待が高まりますし、MathWorks がその発展に貢献していることを誇りに思います。

エッジAI 向けの提供内容について詳しくは、MATLAB and Simulink for Embedded AI をご覧ください。

- Category:

- Artificial Intelligence,

- Community

Comments

To leave a comment, please click here to sign in to your MathWorks Account or create a new one.